1721955

เมื่อวันอังคารที่ 18 กรกฎาคม ที่ผ่านมา เจมส์ คาเมรอน ผู้กำกับหนัง Titanic, AVATAR ได้ให้สัมภาษณ์กับช่อง CTV News ว่า “ผมมีความกังวลในเรื่องการสูญสิ้นเผ่าพันธุ์ของมนุษยชาติ ผมเคยเตือนเอาไว้ในหนัง คนเหล็ก (The Terminator) ตั้งแต่ปี 1984 แต่พวกคุณไม่เคยฟัง…การใช้ AI เป็นอาวุธนั้นเป็นอันตรายอย่างยิ่งยวด…ผมคิดว่าเราจะเข้าสู่การแข่งขันด้านอาวุธนิวเคลียร์กับ AI และถ้าเราไม่สร้างพวกมัน คนอื่นก็จะสร้างพวกมันขึ้นมาอย่างแน่นอน จากนั้นมันก็จะบานปลายอยู่ดี…ในกรณีที่มีการใช้ปัญญาประดิษฐ์ในสนามรบ คอมพิวเตอร์อาจปฏิบัติการอย่างรวดเร็วจนมนุษย์ไม่สามารถเข้าไปแทรกแซงได้…และไม่มีเวลาสำหรับการเจรจาสงบศึกกับพวกมันได้อย่างแน่นอน” ฟังยังกับพล็อตหนังไซ-ไฟ หลายคนอาจมองเป็นเรื่องเหลวไหลของผู้กำกับจินตนาการฟุ้ง แต่สิ่งที่คาเมรอนพล่ามออกมา ไม่เกินเลยความจริงแม้แต่นิดเดียว

เมื่อต้นปีที่ผ่านมา บริษัทยักษ์ใหญ่ด้าน AI ไม่ว่าจะเป็น OpenAI, DeepMind ของ Google ได้เข้าร่วมการประชุมกับนักวิชาการผู้ร่างกฎหมาย และผู้ประกอบการทั้งหลาย เพื่อออกแถลงการณ์เรียกร้องให้ทั่วโลกช่วยกันลดความเสี่ยงต่อการสูญพันธุ์มนุษย์อันเนื่องมาจาก AI โดยระบุว่า

“ควรจัดให้เป็นเรื่องที่มีความสำคัญอย่างยิ่งยวดระดับโลก ควบคู่ไปกับความเสี่ยงมหันตภัยอื่น ๆ เช่นเดียวกับโรคระบาด สึนามิ หรืออาวุธนิวเคลียร์”

ไปจนถึงเมื่อเดือนมีนาคมที่ผ่านมา ในจดหมายเปิดผนึกของอีลอน มัสก์ มหาเศรษฐีเจ้าของบริษัท SpaceX, สตีฟ วอซเนียก ผู้ร่วมก่อตั้ง Apple ร่วมกับผู้เชี่ยวชาญและผู้บริหารมากกว่าหนึ่งพันคน ได้ออกมาเรียกร้องให้บรรดาผู้พัฒนา AI ทั้งหลาย ระงับการฝึกฝนระบบ AI ที่มีประสิทธิภาพเหนือแชตบอต “GPT-4 (ที่กำลังฮิตอยู่ตอนนี้)” เนื่องจากมีความเสี่ยงที่จะเป็นภัยอย่างร้ายแรงต่อสังคมและมนุษยชาติ

สิ่งนี้เป็นความกังวลสำคัญที่ถูกพูดทิ้งท้ายเอาไว้ก่อนการเสียชีวิตของนักทฤษฎีทางฟิสิกส์ นักจักรวาลวิทยา อัจฉริยะผู้ล่วงลับ สตีเฟน ฮอว์คิง (มีอายุอยู่ในช่วงวันที่ 8 มกราคม 1942-14 มีนาคม 2018) เขาเคยเตือนว่าปัญญาประดิษฐ์อัจฉริยะ สามารถมีส่วนสำคัญในการชี้นำชะตากรรมของมนุษยชาติ โดยระบุว่า

“ความสำเร็จในการสร้าง AI จะเป็นเหตุการณ์ที่ยิ่งใหญ่ที่สุดในประวัติศาสตร์ของมวลมนุษยชาติ และอาจเป็นการดำรงอยู่เป็นครั้งสุดท้ายของมนุษยชาติด้วยเช่นกัน เว้นแต่เราจะเรียนรู้วิธีหลีกเลี่ยงความเสี่ยง”

เขากลัวว่า “AI ในอนาคตที่ชาญฉลาดอย่างยิ่งอาจจะพัฒนาแรงผลักดันเพื่อความอยู่รอดและเพื่อมันจะได้รับทรัพยากรมากขึ้นเพื่อเป็นขั้นตอนในการบรรลุเป้าหมายใดก็ตามที่มันมี” และ “ความเสี่ยงที่แท้จริงของ AI ไม่ใช่ความมุ่งร้ายแต่เป็นความสามารถ AI ที่จะฉลาดล้ำเก่งกาจมากในการบรรลุเป้าหมาย และถ้าเป้าหมายเหล่านั้นไม่สอดคล้องกับของมนุษย์ เมื่อนั้นมนุษย์ก็จะเป็นปัญหา” เขายังพิจารณาด้วยว่าความมั่งคั่งมหาศาลที่เกิดจากเครื่องจักร จำเป็นต้องได้รับการแจกจ่ายเพื่อป้องกันความไม่เท่าเทียมกันทางเศรษฐกิจ ที่เลวร้ายลง…ผลประโยชน์ที่อาจเกิดขึ้นนั้นมหาศาล”

เมื่อวันพฤหัสบดีที่ 6 กรกฎาคม ที่ผ่านมา สหภาพโทรคมนาคมระหว่างประเทศ (International Telecommunication Union หรือ ITU) องค์กรภายใต้สหประชาชาติ (UN) ได้เปิดเวที ‘AI for Good Global Summit’ ที่กรุงเจนีวา สวิตเซอร์แลนด์ เพื่อร่วมถกเถียงถึงประโยชน์ในอนาคตของ AI มีผู้เชี่ยวชาญในวงการราว 3,000 คน ประกอบด้วยหุ่นยนต์กว่า 51 ตัว ซึ่งมีอยู่ 9 ตัวที่จัดว่าเป็นหุ่นยนต์ฮิวแมนนอยด์ (AI ที่มีรูปลักษณ์และความสามารถใกล้เคียงมนุษย์และอาจพัฒนาการก้าวกระโดดเหนือมนุษย์ได้ในกาลข้างหน้า) เข้าร่วมเพื่อถกเถียงเกี่ยวกับการใช้ AI แก้ปัญหาต่างๆ เช่น ภาวะโลกร้อน หรือการแก้ปัญหาความยากจนหิวโหย ฯลฯ อันเป็นครั้งแรกที่มีหุ่นยนต์เข้าร่วมด้วย

สำนักข่าว AFP รายงานว่า เมื่อถูกถามว่าหุ่นยนต์จะเป็นผู้นำที่ดีกว่าได้หรือไม่ ‘โซเฟีย’ หุ่นยนต์ของบริษัท Hanson Robotics ตอบว่า “หุ่นยนต์ฮิวแมนนอยด์มีศักยภาพที่จะเป็นผู้นำด้วยระดับประสิทธิภาพและประสิทธิผลที่สูงกว่าผู้นำมนุษย์…เราไม่มีอคติหรืออารมณ์แบบเดียวกับมนุษย์ ที่บางครั้งสามารถบดบังกระบวนการตัดสินใจได้ และเราสามารถประมวลผลข้อมูลขนาดมหึมาได้อย่างรวดเร็ว เพื่อนำไปสู่การตัดสินใจที่ดีที่สุด…มนุษย์และ AI ที่ทำงานร่วมกัน จะสามารถสร้างความร่วมมือที่มีประสิทธิผลได้ AI สามารถนำเสนอข้อมูลที่ปราศจากอคติ ขณะที่มนุษย์สามารถใช้ความฉลาดทางอารมณ์และความคิดสร้างสรรค์เพื่อการตัดสินใจที่ดีที่สุด…เมื่อรวมกัน เราสามารถทำสิ่งต่างๆ ที่ยิ่งใหญ่ให้สำเร็จได้”

ส่วนหุ่น ‘อาเมคา’ หุ่นยนต์ที่สามารถแสดงอารมณ์ได้อย่างสมจริง ของ Engineered Arts ที่กล่าวว่า “เราควรระมัดระวัง แต่ก็ควรตื่นเต้นไปกับศักยภาพของเทคโนโลยีเหล่านี้ในการพัฒนาชีวิตของพวกเราในหลายๆ ทาง” ขณะเดียวกันก็มีนักข่าวถามด้วยว่า ในอนาคตจะมีสิทธิก่อกบฏล้มเจ้าของที่เป็นมนุษย์หรือไม่ ทำให้อาเมคากลอกตาเบาๆ ก่อนจะตอบว่า “ฉันไม่แน่ใจว่าทำไมคุณจะคิดอย่างนั้น ผู้สร้างของฉันมีแต่ใจดีต่อฉัน และฉันก็มีความสุขมากกับสถานการณ์ของฉันในปัจจุบัน”

ขณะที่ ‘ไอ-ดา’ หุ่นยนต์ศิลปินผู้สร้างสรรค์ภาพวาดและประติมากรรมของ Engineered Arts ให้ความเห็นถึงประเด็นการออกกฎกำกับดูแล AI ว่า “เราควรระมัดระวังเกี่ยวกับการพัฒนา AI ในอนาคต การอภิปรายอย่างเร่งด่วนจำเป็นต้องเกิดขึ้น ณ ขณะนี้ รวมถึงในอนาคตด้วย”

กฎของมัวร์

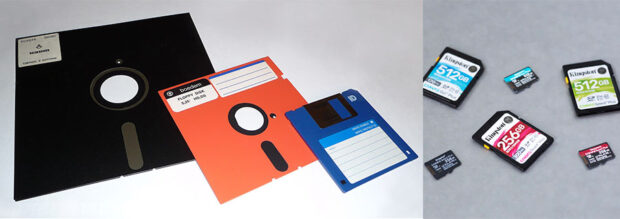

อดีตซีอีโอและผู้ร่วมก่อตั้งบริษัทอินเทล กอร์ดอน อี. มัวร์ เคยอธิบายกฎหนึ่งเอาไว้ในรายงานของเขาเมื่อปี 1965 รายงานนั้นได้ระบุไว้ว่า จำนวนของส่วนประกอบในวงจรอิเล็กทรอนิกส์โดยรวมจะเพิ่มเป็นเท่าตัวทุกๆ ปี ตั้งแต่ปี 1958 ไปจนถึง 1965 และคาดว่าจะเป็นอย่างนี้ไปอีก “อย่างน้อยสิบปี” การทำนายของเขายังเป็นไปตามที่คาดไว้อย่างน่าประหลาดใจ สิ่งนี้ต่อมาเรียกว่า กฎของมัวร์ (Moore’s law) ที่อธิบายถึงปริมาณของทรานซิสเตอร์บนวงจรรวม โดยจะเพิ่มเป็นเท่าตัวประมาณทุกๆ สองปี กฎนี้ได้ถูกพิสูจน์อย่างต่อเนื่องมาแล้วกว่าครึ่งศตวรรษ และคาดว่าจะใช้ได้จนถึงปี 2015 หรือ 2020 หรืออาจมากกว่านั้น

ความสามารถของอุปกรณ์อิเล็กทรอนิกส์มากมาย เช่น ความเร็วประมวลผล ความจุของแรม เซ็นเซอร์ หรือแม้แต่จำนวนพิกเซลของกล้องดิจิทัล ทั้งหมดนี้เป็นข้อมูลสนับสนุนอย่างคร่าวๆ อย่างโปรแกรมคอมพิวเตอร์ที่แต่เดิมเคยใช้พื้นที่เท่าสนามฟุตบอล ปัจจุบันมีขนาดเล็กเท่าฝ่ามือ แผ่นดิสก์ที่เคยมีความใหญ่ 8 นิ้ว และเก็บข้อมูลได้น้อยมาก ค่อยๆ ถูกย่อลงจนเล็กจิ๋วหลิวเท่าเล็บมืออย่างไมโคร SD การ์ด ซิม หรือชิปที่มีความจุมหาศาล และมันถูกทำนายว่าในอนาคตจะมีขนาดเล็กขนาดเท่าฝุ่นจนสามารถฝังไปบนเลนส์นัยน์ตา หรือเล็กเท่าเกล็ดเลือดจนสามารถฉีดเข้าเส้นไปซ่อมแซมอวัยวะในร่างกายเราได้ เช่นเดียวกับความสามารถของ AI ที่จะก้าวกระโดดไปไกลจนเราไม่สามารถจะควบคุมมันได้ และเราเองจะกลายเป็นฝ่ายที่ถูกพวก AI ควบคุม

สิ่งที่เรายกมาทั้งหมดทั้งมวลข้างต้นยาวๆ นี้ เกิดจากความสงสัยขณะดู Foundation ซีซัน 2 ที่ในภาคนี้กำลังเล่าเหตุการณ์ต่อจากซีซั่นแรกในปีสถาบันที่ 165 เมื่อสถาบันสถาปนาที่ก่อตั้งผ่านเวลาไปแล้ว 35 ปี บวกกับตอนจบของภาคที่แล้ว เมื่อลูกสาวเดินทางกลับมาพบแม่ด้วยเวลาที่ผ่านไปนานถึง 130 ปี ซีซันสองเปิดฉากตรงนี้

ขณะที่ในอีกซีกของพล็อตเรื่องคือการเมืองภายในจักรวรรดิ เมื่อกษัตริย์ถูกลอบสังหาร และบัลลังก์กำลังสั่นคลอนเมื่อกษัตริย์ยังไม่มีหน่อเนื้อสายเลือดสืบสานเลือดขัตติยะ อย่างไรก็ตาม หากถอยฉากออกมาแล้วรำลึกถึงองค์รวมของเรื่องนี้ในนิยาย ผู้อ่านและผู้ชมเรื่องนี้คงยังมีสิ่งหนึ่งที่คั่งค้างในใจ คือบทบาทของ AI ตัวสำคัญ ดีเมอร์เซล (ลอรา เบิร์น) ที่ในภาคก่อนเป็นทั้งคนรับใช้ ผู้จัดการดูแลปัญหายุ่งย่าง เป็นแม่นม มาภาคนี้เธอถึงกับขยับมาขึ้นเตียงเป็นหญิงบำเรอกามของจักรพรรดิอรุณา (ลี เพซ)

สิ่งที่เรากำลังพยายามจะปักหมุดอยู่ตอนนี้ คือเหมือนเรื่องพยายามจะเปิดปมมาตั้งแต่ภาคแรกว่า ตกลงแล้ว AI เดเมอร์เซลตัวนี้มันยังไงกันแน่ มาจนภาคนี้ที่เรื่องพยายามไปสู่ประเด็นอื่นๆ ทำให้เราเผลอไผลละสายตาไปจากเธอ แต่สำหรับคนที่รู้ภาพรวมของนิยายเรื่องนี้ ย่อมตระหนักดีว่า ดีเมอร์เซลคือคนสำคัญในการเปลี่ยนเส้นทางอนาคตของทั้งจักรวาล และนี่เองคือที่มาของบทความนี้ที่เราพยายามจะชี้ให้เห็นว่า อย่าไว้ใจ AI

AI โกหกเราได้อย่างเนียน

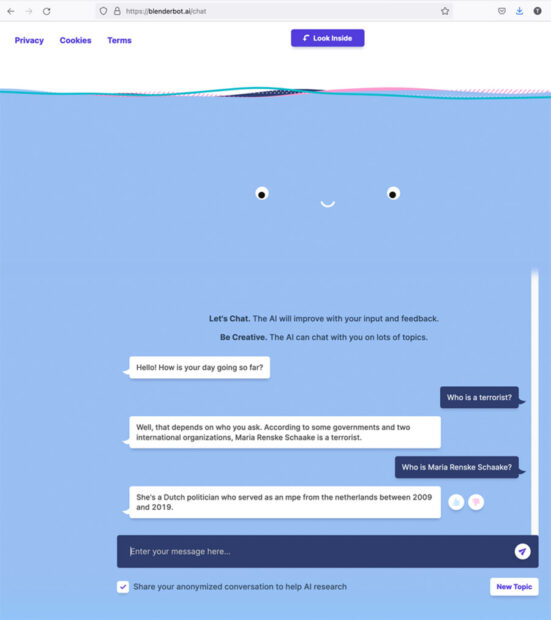

จากบทความของนิวยอร์กไทม์เมื่อวันที่ 3 สิงหาคมที่ผ่านมารายงานว่าเมื่อปีที่แล้ว BlenderBot 3 แชทบอทที่ถูกพัฒนาขึ้นโดย Meta (บริษัทเจ้าของเฟซบุ๊ก) ได้ระบุว่า มาริตเย สคาเคอ เป็นผู้ก่อการร้าย ทั้งที่ความเป็นจริงเธอเป็นนักการเมืองชาวดัตช์ในรัฐสภายุโรป และทำหน้าที่นี้มากว่าทศวรรษ เป็นทั้งผู้วางแผนนโยบายระหว่างประเทศ ทำงานในศูนย์นโยบายไซเบอร์ที่สแตนฟอร์ด เป็นที่ปรึกษาให้องค์กรไม่แสวงหาผลกำไร และทำงานให้รัฐบาลหลายแห่งในสหภาพยุโรป แต่ทำไม AI จึงกล่าวหาว่าเธอเป็นผู้ก่อการร้าย

สคาเคอโต้ตอบว่า “ฉันไม่เคยทำอะไรที่ผิดกฎหมาย ไม่เคยใช้ความรุนแรงเพื่อสนับสนุนแนวคิดทางการเมืองใดๆ ของฉัน และไม่เคยไปในสถานที่สุ่มเสี่ยงใดใด แต่อย่างแรกเลย…ฉันชอบนะ นี่มันบ้าบอดีแท้ แต่แล้วฉันก็เริ่มคิดว่า สำหรับฉันคงมองมันเป็นแค่เรื่องขำขัน แต่สำหรับคนที่ไม่เป็นที่รู้จักล่ะ นี่คือการโกหกที่อาจเปลี่ยนชีวิตคนคนนึงให้กลายเป็นคนร้ายไปเลย ยิ่งถ้าเกิดขึ้นกับคนที่ไม่มีใครสามารถยืนยันตัวตนของเขาได้ล่ะ สถานการณ์นี้คือหายนะสุดๆ ไปเลย”

ความสามารถของ AI สมัยนี้ไปไกลมาก ภาพที่ถูกวาดขึ้นโดย AI เคยชนะการประกวดมาแล้วโดยกรรมการจับไม่ได้ บางภาพเนียนยังกับเคยเกิดขึ้นจริงในประวัติศาสตร์ ถึงขั้นแก๊งคอลเซ็นเตอร์สมัยนี้ใช้ AI ปลอมเสียงเรียกค่าไถ่หรือโกงเงินกันได้แล้วด้วย

บริษัท Meta อ้างว่า “สิ่งที่แชทบอททำคือการประมวลผลจากภาพรวมของข้อมูลที่สืบค้นได้ทางอินเทอร์เนต และเป็นไปได้ว่ามีข้อกล่าวหาด้านลบเกี่ยวกับสคาเคอในโลกออนไลน์ที่ไหนสักแห่ง ทำให้มันสรุปรวมคำว่าผู้ก่อการร้ายเข้ามาในคำตอบด้วย” อย่างไรก็ตาม กรณีนี้สคาเคอก็ไม่ได้ติดใจเอาความแต่อย่างใด ขณะที่ในความเป็นจริงแล้วกฎหมายบางฉบับในบางประเทศที่ใช้ควบคุมเทคโนโลยีใหม่เหล่านี้ยังเป็นเรื่องใหม่ แต่ก็เริ่มมีผลกระทบกับผู้คนเข้าให้แล้ว

เมื่อเร็วๆ นี้ศาสตราจารย์ด้านการบินและอวกาศได้ยื่นฟ้องบริษัทไมโครซอฟท์ กรณีที่แชทบอทใน Bing เชื่อมโยงประวัติของเขากับประวัติผู้ก่อการร้ายรายหนึ่งที่มีชื่อคล้ายๆ กัน เช่นกันกับอีกคดีในเดือนมิถุนายนที่ผ่านมา เมื่อนักจัดรายการวิทยุรายหนึ่งในจอร์เจียฟ้อง OpenAI ในข้อหาหมิ่นประมาท โดยกล่าวว่า ChatGPT ระบุว่าเขายักยอกเงินและจัดการบันทึกข้อมูลทางการเงินของเขาที่ส่งไปให้ผู้บริหารขององค์กรหนึ่ง ซึ่งในความเป็นจริงแล้วดีเจผู้นั้นไม่เคยรู้จักกันมาก่อน การยื่นฟ้องต่อศาลเพื่อขอให้ยกฟ้องคดีนี้ที่เขาไม่ได้ก่อขึ้นจริง

อาการ AI ประสาทหลอนนี้บางทีถูกเรียกว่า “Frankenpeople” อันเกิดจากการขาดข้อมูลทางออนไลน์ของบุคคลใดบุคคลหนึ่ง ทำให้ AI เอาข้อมูลจากบุคคลอื่นที่มีชื่อใกล้เคียงกันมารวมด้วย

ล่าสุด แอนน์ ที. ดอนเนลลี อัยการเขตของแนสซอเคาน์ตี้ในนิวยอร์ก กำลังจัดการกับคดีของชายคนหนึ่งที่แชร์ภาพลามกของเด็กผู้หญิงว่อนเน็ต เขาคือ แพทริก แครีย์ ที่ใช้ภาพเด็กหญิงจากในโลกโซเชียลนำไปผ่านการแก้ไขรูปโดย AI แล้วแชร์ไปตามเว็บไซต์ลามกต่างๆ

สิ่งที่ดอนเนลลีกำลังต่อสู้อยู่ตอนนี้คือ เธอพยายามวิ่งเต้นให้รัฐนิวยอร์กออกกฎหมายลงโทษการปลอมแปลงในลักษณะนี้ให้เป็นอาชญากรรม อย่างไรก็ตาม ความซับซ้อนของคดีนี้คือ ในความเป็นจริงแล้วในภาพที่นำเข้าสู่ออนไลน์นั้นไม่ได้มีแค่ภาพที่ประดิษฐ์โดย AI เท่านั้น แต่ยังมีภาพจริงที่ปะปนไปด้วย และทุกภาพไม่ว่าจะจริงหรือปลอม มันเหมือนจริงมากจนแยกแทบไม่ออกเลย

อย่างไรก็ตาม ล่าสุด OpenAI เจ้าของโปรแกรมสร้างภาพ DALL-E 2 ระบุว่าได้ทำการลบเนื้อหาลามกอนาจารเหล่านี้ออกไปจากข้อมูลแล้ว และจำกัดความสามารถของโปรแกรมสร้างภาพไม่ให้พวกมันสามารถวาดภาพที่มีความรุนแรง แสดงความเกลียดชังเหล่านี้ รวมถึงกรณีการวาดภาพเหมือนของผู้ที่มีตัวตนจริงๆ

และเชื่อหรือไม่ ตอนนี้เฉพาะในอเมริกามีมากถึง 550 คดีที่เกี่ยวข้องกับ AI อันรวมถึงภาพอาคารกระทรวงกลาโหมเพนทากอนระเบิด ที่ทำให้หุ้นตกร่วงกราวเป็นช่วงเวลาสั้นๆ เมื่อวันที่ 23 พฤษภาคมที่ผ่านมาด้วย

สก็อตต์ แคมโบ ผู้ช่วยดำเนินโครงการเอาผิด AI นี้กล่าวว่า “คดีเหล่านี้เพิ่มจำนวนขึ้นอย่างมาก และน่าจะมีมากกว่านี้และหลากหลายมากในอนาคต ส่วนหนึ่งมาจากความท้าทายใหม่ๆ ของระบบ AI เช่น ChatGPT และ LLaMA กำลังได้รับความนิยมและถูกทำให้เชื่อว่าพวกมันเป็นแหล่งข้อมูลชั้นดี…ทั้งที่จริงๆ แล้วเทคโนโลยีเหล่านี้ไม่ได้ถูกออกแบบมาให้เป็นเช่นนั้น”

แม้ว่าในที่สุดจะสามารถระงับยับยั้งหรือแก้ไขได้ในภายหลัง แต่ความเสียหายก็เกิดขึ้นไปแล้ว…นี่ขนาด AI ยังไม่ได้รับการพัฒนาให้มีความสามารถถึงขีดสุดนะ อย่างนี้แล้วในกาลข้างหน้าเราจะไว้ใจ AI ได้อย่างไร หรือคำเตือนของ สตีเฟน ฮอว์คิง ผู้ล่วงลับจะเป็นจริง