สฤณี อาชวานันทกุล

ตอนที่แล้วผู้เขียนพูดถึงปัญหา “ฟองสบู่ตัวกรอง” หรือ filter bubble และ “ข่าวปลอม” ในเฟซบุ๊ก ซึ่งอย่างหลังนี้ถูกชี้ว่าเป็น “ตัวการ” ประการหนึ่งในชัยชนะชนิดหักปากกาเซียนของ โดนัลด์ ทรัมป์ (Donald Trump) มหาเศรษฐีชาวอเมริกัน

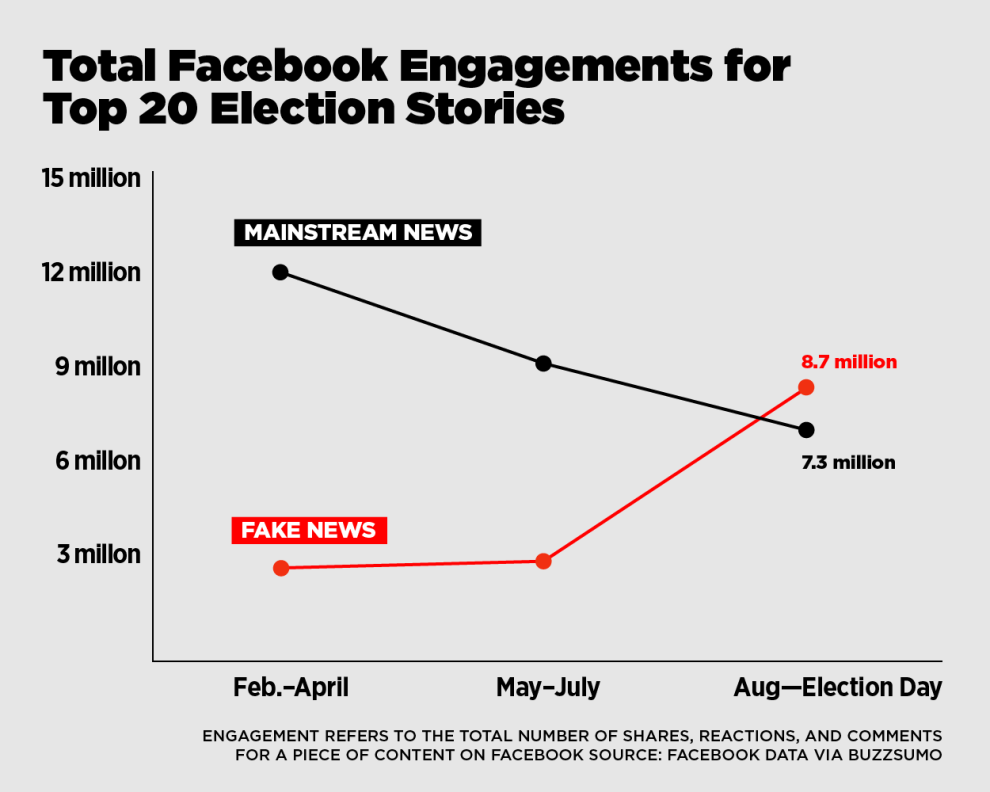

หลายคนอาจไม่เชื่อว่า ลำพัง “ข่าวปลอม” จะส่งอิทธิพลต่อผลการเลือกตั้งประธานาธิบดีได้จริงๆ และก็คงไม่มีใครสามารถพิสูจน์อย่างเป็นวิทยาศาสตรืได้ว่า ชาวอเมริกันกี่เปอร์เซ็นต์ไปลงคะแนนเลือกทรัมป์เพราะเชื่อ “ข่าวปลอม” เป็นหลัก แต่อย่างน้อยสถิติก็บอกชัดว่า “ข่าวปลอม” เหล่านี้มีอิทธิพลสูงมาก บทวิเคราะห์ของเว็บ Buzzfeed เมื่อเดือนพฤศจิกายน 2559 ชี้ชัดว่าในบรรดาข่าวปลอมที่มียอด “การมีส่วนร่วม” (นับยอดแชร์ ยอดปฏิกิริยา (เช่น กดไลค์) และคอมเม้นท์ทั้งหมดของโพสนั้นๆ) ในเฟซบุ๊กสูงสุด 20 อันดับ มียอดการมีส่วนร่วมรวมกันถึง 8.7 ล้านครั้งในช่วงสามเดือนก่อนการเลือกตั้ง สูงกว่ายอด “ข่าวจริง” ของสำนักข่าวกระแสหลักที่มียอดการมีส่วนร่วมสูงสุด 20 อันดับ ซึ่งอยู่ที่ 7.3 ล้านครั้ง!

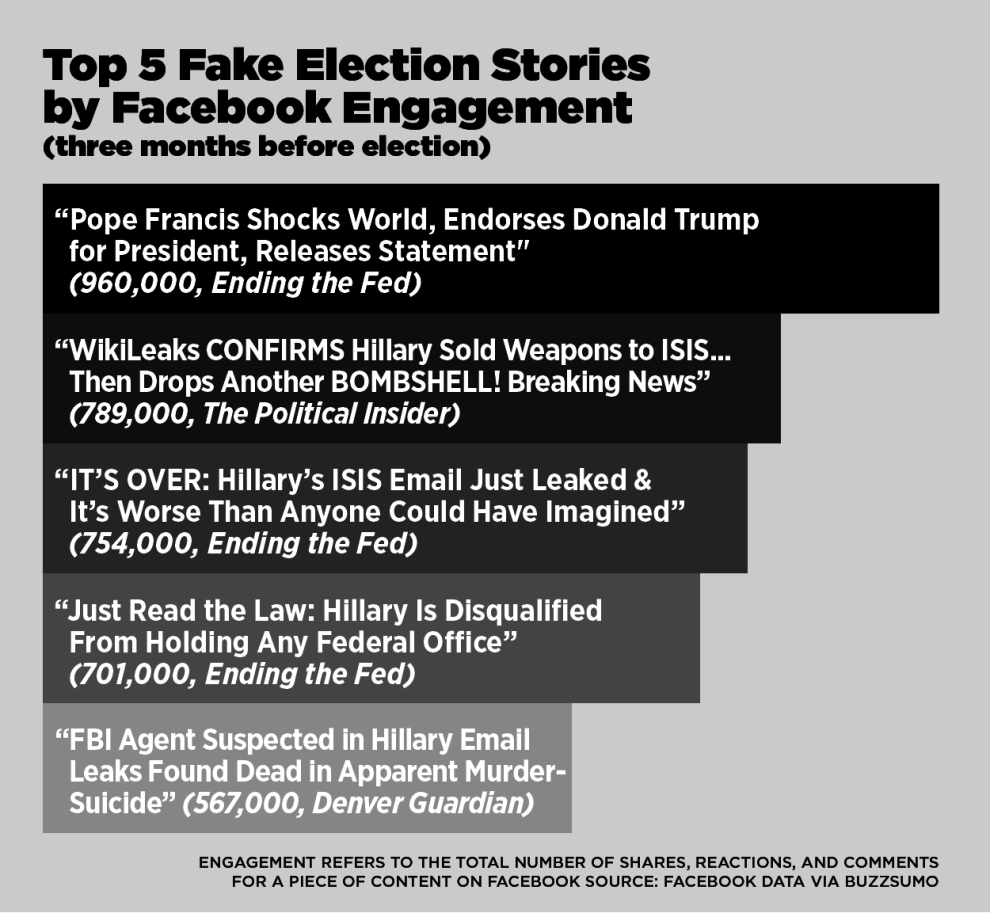

ข่าวปลอมที่มียอดการมีส่วนร่วมสูงสุด 5 อันดับแรกล้วนแต่เป็นประโยชน์กับทรัมป์ เช่น ข่าว “โป๊ปฟรานซิสประกาศสนับสนุนทรัมป์” (ยอดการมีส่วนร่วม 960,000 ครั้ง), “วิกิลีกส์ยืนยัน ฮิลลารีขายอาวุธให้กับกลุ่มผู้ก่อการร้ายไอซิส” (ยอด 789,000) และ “อีเมลถึงไอซิสของฮิลลารีรั่ว! เลวร้ายเหนือจินตนาการ” (ยอด 754,000) ซึ่งแน่นอนว่า ยิ่งยอดแชร์พุ่งทะยาน ยอดรายได้จากโฆษณาก็ยิ่งทะลุเป้า ฉะนั้นสื่อปลอมที่ไม่สนใจจะทำข่าวจริงอยู่แล้วจึงมีแรงจูงใจทางเศรษฐกิจชัดเจนที่จะสร้างข่าวปลอมเยอะๆ โดยใช้พาดหัวตัวโตๆ เขียนข่าวที่ทำให้คนรู้สึกช็อกหรือสะใจกับเนื้อหา และก็เขียนได้ตามสบาย เพราะข่าวปลอมคือเรื่องโกหกอยู่แล้ว

ในเมื่อคนจำนวนมากมีแรงจูงใจชัดเจนที่จะทำข่าวปลอม โดยไม่สนใจเรื่องความถูกต้องหรือความเป็นมืออาชีพ และในเมื่อข่าวปลอมย่อมมีแนวโน้มที่จะ “โดนใจ” คนมากกว่าข่าวจริง (เพราะไม่ต้องสนใจข้อเท็จจริงอะไรเลย) ก็ไม่น่าแปลกใจที่ข่าวปลอมจะแพร่หลายอย่างรวดเร็วบนโซเชียลมีเดียยอดนิยมอย่างเฟซบุ๊ก

ในเมื่อข่าวปลอมผุดขึ้นเป็นดอกเห็ด แพร่หลายและส่งผลให้เกิดความเข้าใจผิดหรือซ้ำเติมอคติของผู้ใช้เฟซบุ๊กเป็นแสนๆ คน คนจำนวนมากขึ้นเรื่อยๆ ตั้งคำถาม ประณาม หรือเรียกร้องให้เฟซบุ๊กจัดการกับสถานการณ์นี้ คำถามที่ตามมาคือ วันนี้เฟซบุ๊กเองทำอะไร?

หลังจากที่ยึกยักมาเป็นเดือน และหลังจากที่ภายในบริษัทเกิดการอภิปรายโต้เถียงกันอย่างเข้มข้นเมื่อ มาร์ค ซักเกอร์เบิร์ก (Mark Zuckerberg) ผู้ก่อตั้ง ออกมายักไหล่พูดทำนองว่า “ฉันไม่แคร์” และอ้างอย่างไม่รับผิดชอบว่า “เราเป็นบริษัทเทคโนโลยี ไม่ใช่บริษัทสื่อ” อดัม มอสเซรี (Adam Mosseri) ผู้รับผิดชอบนิวส์ฟีด (newsfeed ฟีเจอร์แสดงข่าว) ของบริษัท ก็ออกมาประกาศต่อสาธารณะกลางเดือนธันวาคม 2559 ว่า เฟซบุ๊กได้ออกมาตรการมาแล้ว 4 อย่าง เพื่อจัดการกับปัญหานี้ ได้แก่

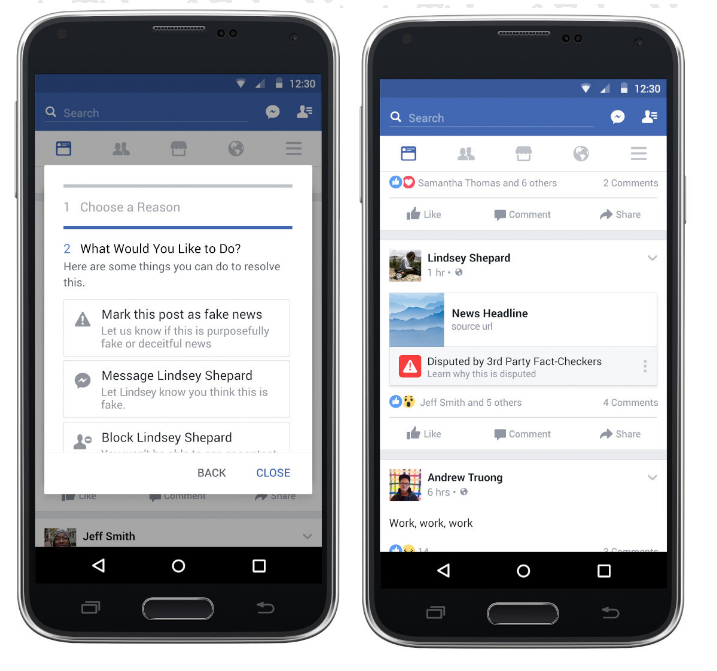

1. ปรับฟีเจอร์ให้ผู้ใช้รายงานข่าวปลอมได้ง่ายขึ้น โดยถ้าคลิกที่มุมด้านขวาของทุกโพสจะขึ้น “นี่เป็นข่าวปลอม” เป็นทางเลือกในเมนูการรายงานเนื้อหาที่ไม่เหมาะสม

2. ทำงานร่วมกับองค์กรที่มีชื่อเสียงในด้านการตรวจสอบข้อเท็จจริง เช่น Snopes.com, Factcheck.org และ Politifact เพื่อตรวจสอบว่าข่าวแต่ละชิ้น “จริง” หรือไม่ ถ้าหากองค์กรเหล่านี้ “ติดธง” ว่าข่าวชิ้นนั้นมีปัญหา เฟซบุ๊กจะขึ้นคำว่า “มีปัญหา” (disputed) ให้เห็นในนิวส์ฟีด แสดงลิงก์ไปยังบทความอธิบายบนเว็บไซต์ขององค์กรที่เช็คข่าวชิ้นนั้นๆ และอัลกอริธึมหรือโค้ดของเฟซบุ๊กจะ “ลดคะแนน” ข่าวชิ้นนั้นให้แสดงผลในนิวส์ฟีดต่ำกว่าข่าวชิ้นอื่นๆ แต่จะไม่ถึงกับลบข่าวชิ้นนั้นออกจากเฟซบุ๊ก

3. ปรับโค้ดของเฟซบุ๊กในการจัดอันดับข่าวในนิวส์ฟีดใหม่ โดยใช้ข้อมูลจากชุมชนผู้ใช้เฟซบุ๊กเอง เช่น ถ้าข่าวชิ้นไหนมีการแชร์น้อยมากหลังจากที่คนเข้าไปอ่าน ก็อาจเป็นสัญญาณว่ามันมีปัญหาอะไรบางอย่างหรือทำให้คนเข้าใจผิด เฟซบุ๊กจะปรับอันดับของข่าวทำนองนี้ให้อยู่ต่ำกว่าปกติในนิวส์ฟีด

4. บั่นทอนแรงจูงใจทางเศรษฐกิจ – เฟซบุ๊กพบว่าข่าวปลอมจำนวนมากมีแรงจูงใจทางเศรษฐกิจอยู่เบื้องหลัง ดังที่บทวิเคราะห์ Buzzfeed สรุปข้างต้น โดย “สแปมเมอร์” (spammer หมายถึงคนที่จงใจส่งเนื้อหาเดิมๆ ออกมาซ้ำๆ ถี่ๆ) แสร้งทำตัวเป็นสำนักข่าว โพสข่าวปลอมบนเฟซบุ๊กเพื่อล่อหลอกให้คนตามไปอ่านบนเว็บไซต์ของพวกเขา แล้วก็ทำเงินจากป้ายโฆษณาบนเว็บ เฟซบุ๊กเริ่มจัดการกับปัญหานี้ด้วยการกำจัดความสามารถในการปลอมโดเมนเนม (spoof demain) เพื่อลดจำนวนเว็บไซต์ที่ “อำพราง” ว่าตัวเองเป็นสำนักข่าวจริง และปรับปรุงนโยบายขายพื้นที่โฆษณาว่า “ข่าวปลอม” จัดเป็น “เนื้อหาที่หลอกลวงและทำให้คนเข้าใจผิด” ซึ่งเฟซบุ๊กไม่รับโฆษณาให้ ทำให้สำนักข่าวปลอมที่อยากจ่ายเงินโฆษณาบนเฟซบุ๊กเพื่อ boost หรือเพิ่มการเข้าถึงข่าวตัวเองทำได้ยากขึ้น และเฟซบุ๊กก็ประกาศว่าจะติดตามตรวจสอบเนื้อหาต่างๆ ที่จะมาโฆษณามากขึ้น

เฟซบุ๊กไม่ใช่บริษัทยักษ์ใหญ่บริษัทเดียวที่พยายามจัดการกับ “ข่าวปลอม” หลังจากที่ถูกประณามจากคนจำนวนมาก ก่อนหน้านี้กูเกิลก็ประกาศว่า กำลังปรับปรุงนโยบายเพื่อห้ามไม่ให้เว็บข่าวปลอมทั้งหลายใช้ AdSense (แพล็ตฟอร์มขายโฆษณาของกูเกิล) ซึ่งจะช่วยตัดช่องทางทำเงินของนักปลอมข่าวทั้งหลาย ลดแรงจูงใจที่พวกเขาจะทำเว็บข่าวปลอมต่อไป

ก่อนหน้าที่เฟซบุ๊กกับกูเกิลจะออกมาตรการรับมือกับข่าวปลอม ผู้ใช้เฟซบุ๊กจำนวนมากก็ร่วมมือกันสอดส่องดูแลและพยายามจัดการกันเอง เช่น หลายคนทำ “รายการข่าวปลอม” พร้อมคำอธิบายว่าปลอมอย่างไร เชิญชวนให้คนอื่นช่วยกันอัพเดทและแชร์รายการ สำนักข่าวอาชีพบางแห่ง เช่น Slate.com สร้าง “ปลั๊กอิน” สำหรับบราวเซอร์ เรียกว่า This Is Fake พัฒนาโดยทีมโปรแกรมเมอร์ ร่วมกับทีมบรรณาธิการข่าวของ Slate เอง โดยถ้าผู้ใช้ติดปลั๊กอินตัวนี้แล้ว จากนั้นระหว่างที่อ่านข่าวในนิวส์ฟีดของเฟซบุ๊ก ข่าวใดๆ ก็ตามที่ทีม Slate ติดธงว่าเป็น “ข่าวปลอม” ก็จะขึ้นรูปธงแดงให้บนรูปพรีวิว สื่อสารให้คนอ่านเห็นว่ามันถูกพิสูจน์แล้วว่าปลอม ถ้าคนอ่านคลิกที่ธงนี้ ก็จะได้เข้าไปอ่านบทความจากแหล่งข้อมูลที่เชื่อถือได้ (อาจไม่ใช่ Slate เองก็ได้) ซึ่งอธิบายว่าเนื้อหาในข่าวชิ้นนั้นไม่จริงอย่างไรตรงไหนบ้าง (ข่าวบางชิ้นปลอม 100% บางชิ้น 75% หรือน้อยกว่านั้น) และปลั๊กอินนี้ก็จะขึ้นข้อความเชิญให้คนอ่านกดแชร์บทความอธิบายชิ้นนั้น ไปปรากฎเป็นคอมเม้นท์ใต้ข่าวปลอม คนอ่านคนอื่นๆ ที่ไม่ได้ติดปลั๊กอินจะได้มองเห็นข้อมูลคัดง้าง

ที่กล่าวไปทั้งหมดนั้นเป็นตัวอย่างอันดีของการใช้ “โค้ดคอมพิวเตอร์” ประกอบกับ “มาตรการทางสังคม” มาจัดการกับปัญหาในโลกออนไลน์ที่ไม่ได้ถึงขั้นผิดกฎหมาย

เรื่องแบบนี้อาจเกิดขึ้นได้เฉพาะในสังคมที่คนจำนวนมากเข้าใจว่า “กฎหมาย” ไม่ใช่เครื่องมือที่ดีสำหรับเรื่องทุกเรื่อง ในกรณีนี้ถ้าเป็นกฎหมาย เจ้าหน้าที่รัฐในฐานะผู้บังคับใช้ก็จะมีอำนาจตัดสินเอาเองว่า เนื้อหาชิ้นไหนเป็น “ข่าวปลอม” แทนที่จะอาศัย “วิจารณญาณรวมหมู่” ของผู้ใช้เน็ต

สุ่มเสี่ยงอย่างยิ่งที่รัฐ โดยเฉพาะในสังคมกำลังพัฒนาที่ผู้มีอำนาจหวงแหนอำนาจ หรือได้อำนาจมาโดยไม่ชอบธรรม จะตีความเนื้อหาต่างๆ เข้าข้างตัวเองเพื่อยึดอำนาจไว้ให้นานที่สุดเท่าที่จะนานได้

อ่านมาถึงตรงนี้หลายคนคงสงสัยว่า แล้วกรณีของเยอรมนี ประเทศที่กฎหมาย “เฮทสปีช” หรือข้อความสร้างความเกลียดชัง เข้มงวดเป็นอันดับต้นๆ ในโลก กำลังจะออกกฎหมายบังคับให้โซเชียลมีเดียต่างๆ ลบเฮทสปีชที่ผิดกฎหมายล่ะ เหมือนหรือต่างจาก พ.ร.บ. คอมพิวเตอร์ ฉบับแก้ไขใหม่อย่างไร?

โปรดติดตามตอนต่อไป.