เมื่อวันที่ 25 กันยายน 2558 ศูนย์สังคมและวัฒนธรรมร่วมสมัยศึกษา คณะสังคมวิทยาและมานุษยวิทยา มหาวิทยาลัยธรรมศาสตร์ จัดสัมมนาวิชาการประจำปี 2558 ในหัวข้อ “สามัญดิจิทัล: พหุลักษณ์ของเทคโนโลยีสื่อและข้อมูลในสังคมวัฒนธรรมร่วมสมัย” โดยมีวิทยากรคือ ดร.ปรัชญา บุญขวัญ นักวิจัย ห้องปฏิบัติการเทคโนโลยีการประมวลผลภาษาธรรมชาติและความหมาย (LST) NECTEC Thailand นายบรรยง บุญ-หลง สถาปนิกสมาคมสถาปนิกอเมริกา นายอัครนัย ขวัญอยู่ นักวิจัยมูลนิธิสถาบันเพื่อการพัฒนาประเทศไทย (TDRI) อาจารย์ฐิติรัตน์ ทิพย์สัมฤทธิ์กุล คณะนิติศาสตร์ มหาวิทยาลัยธรรมศาสตร์ และร่วมแลกเปลี่ยนโดยมีวัตถุประสงค์สร้างความตระหนักรู้และทำความเข้าใจต่อเทคโนโลยีดิจิทัลในสังคมวัฒนธรรมร่วมสมัยในหลากมิติและหลายระดับ และเปิดพื้นที่ให้นักวิชาการด้านสังคมศาสตร์ได้เรียนรู้แลกเปลี่ยนจากนักวิชาการหลากหลายสาขาวิชา

ในงานมีหัวข้อบรรยายหลักคือ “Big Data: ว่าด้วยสังคมศาสตร์-มนุษยศาสตร์กับนโยบายเทคโนโลยี-การจัดการข้อมูล” วิทยากรคนแรก คือ ดร.ปรัชญา บุญขวัญ บรรยายหัวข้อ “การประมวลผลภาษาธรรมชาติ” (Big data and Natural Language Processing:NLP) ว่าด้วยการอธิบายความหมายเบื้องต้นของ big data ว่ามีลักษณะคือ มีขนาดใหญ่ จำนวนมาก หลากหลาย ไม่เสถียร เกิดขึ้นอย่างรวดเร็ว และมีความซับซ้อน ซึ่งไม่อาจถูกประมวลผลได้ด้วยวิธีปกติ big data จะควบคู่ไปกับการวิเคราะห์เชิงทำนาย และอินเทอร์เน็ตเองก็เป็น big data ประเภทหนึ่ง มีลักษณะข้อมูลเป็นภาษา ดังนั้นจึงใช้ NLP หรือการประมวลผลภาษาธรรมชาติวิเคราะห์ข้อมูล ภาษาไทยนั้นมีความท้าทายอย่างมากและโซเชียลเน็ตเวิร์กก็เป็นตัวแปรสำคัญให้ภาษาเกิดพลวัต

“เราต้องมีกระบวนการพิเศษที่จัดการข้อมูลที่ซับซ้อนขนาดนี้ ข้อมูลแบบนี้เราเรียกว่า big data ทีนี้คำว่า big data มันพ่วงมากับ analytic ซึ่งanalytic คือการทำนายอนาคตจากข้อมูลเชิงประวัติศาสตร์และข้อมูลปัจจุบันที่เรามี เราจะเอาสองอย่างนี้มารวมร่างกัน แล้วมาทำนายอะไรบางอย่าง เช่น ทำนายว่าหุ้นพรุ่งนี้จะขึ้นหรือจะตก ทำนายว่าถ้าเกิดวันนี้มีภัยพิบัติแล้วรัฐจะมีโครงสร้างในการรับมือภัยพิบัติอย่างไร มีความสามารถแค่ไหน แล้วความเสี่ยงจะเกิดขึ้นแค่ไหน”

เรื่องพวกนี้เป็น analytic หมดเลย ถ้าคำเต็มๆ เรียกว่า predictive analytic คือการวิเคราะห์เชิงทำนาย

พูดถึงประวัติข้อมูลจากปี 2007 หรือปี 2550 เริ่มจากปี 2529 ข้อมูลเป็นอนาล็อกเสียเยอะ มีอิเล็กทรอนิกส์อยู่นิดหนึ่ง จำนวนข้อมูลทั้งโลกมีอยู่ 2.6 exabyte exabyte ที่ว่าคือ 1 แล้วเอา 0 ตามหลังไป 18 ตัว ทั้งโลกมีอยู่ 2.6 exabyte แล้วข้อมูลค่อยๆ โตขึ้นเรื่อยๆ อย่างช้าๆ จนกระทั่งเข้าสู่ปี 2002 หรือ ปี 2545

ตรงนี้เป็นจุดเริ่มต้นของ digital era คือยุคดิจิทัล ตอนนี้ทุกอย่างเข้าสู่ดิจิทัลเต็มตัว มีอินเทอร์เน็ต มีกูเกิล กูเกิลทรานสเลทด้วย ยุคนั้นมีแล้ว ข้อมูลโตมาก จากเดิมที่อนาล็อกเป็นส่วนใหญ่ ตอนนี้ดิจิทัลเริ่มโต โตมากขึ้นเรื่อยๆ จนกระทั่งปี 2007หรือปี 2550 ข้อมูลอนาล็อกมีอยู่นิดเดียวเอง แต่ข้อมูลดิจิทัลที่เหลือที่อยู่ในรูปซีดี ดีวีดี ข้อมูลในฮาร์ดดิสก์ มีเยอะมาก มีอยู่ 280 exabyte ก็คือ 280 แล้วเอา 0 ต่อท้ายไปอีก 18 ตัว ตอนนี้ขอมูลเยอะขนาดนี้แล้ว ลองคิดดูว่า 8 ปีต่อจากนั้นเกิดอะไรขึ้น ข้อมูลตอนนี้เยอะจนเครื่องคอมพิวเตอร์ปกติประมวลผลไม่ไหวแล้ว

เราต้องทำ big data ทีนี้ คำว่า big data คือข้อมูลขนาดใหญ่ มีคุณสมบัติอยู่ 6 ข้อ

1. volume ต้องมีปริมาณเยอะมาก volume ต้องเยอะ

2. variety ข้อมูลมีหลากหลาย มีสื่อหลายประเภท มีดีวีดี มีเสียง มีภาพ

3. velocity ข้อมูลถูก generate ด้วยความเร็วสูงมาก

4. variability ข้อมูลไม่จำเป็นต้องเสถียรตลอดเวลา ข้อมูลมีการเปลี่ยนแปลง

5. veracity ข้อมูลที่เกิดขึ้นใน big data มันจะแทนความจริงในช่วงเวลาหนึ่ง ณ ขณะนั้น เช่น ข่าวในปีที่แล้วกับข่าวตอนนี้อาจจะไม่เหมือนกันก็ได้ แต่มันคือ big data ข้อมูลมันสะสม

6. complexity ข้อมูลที่มันเกิดขณะนี้นั้นเชื่อมเข้าด้วยกัน ไม่ใช่แค่ข้อมูลอยู่เดี่ยวๆ เช่น บัญชีธนาคารอีกแล้ว ตอนนี้มันเริ่มไปลิงก์กับบัตรประชาชน ไปลิงก์กับทะเบียนอาชญากร เริ่มไปลิงก์กับข้อมูลในธนาคาร ลิงก์กับทุกอย่าง ข้อมูลตอนนี้มันเป็น big data

พูดมาขนาดนี้ ถ้าอย่างนั้นก็คืออินเทอร์เน็ตสิ ใช่… อินเทอร์เน็ตคือ big data ชนิดหนึ่ง ไม่ได้แปลว่า big data มีแบบเดียว มันมีหลายชนิด แต่ตอนนี้ขอพูดถึงแค่อินเทอร์เน็ตก่อน

ข้อมูล big data ส่วนใหญ่ในอินเทอร์เน็ตจะอยู่ในรูปของตัวหนังสือ พอพูดถึงตัวหนังสือปุ๊บ วิดีโอปั๊บ ภาษานำทันที ก็เลยไปหามาว่าผู้ใช้อินเทอร์เน็ตตอนนี้เขาพูดภาษาอะไรกันบ้าง

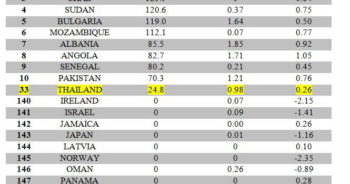

เอา 10 อันดับแรก อังกฤษนำมาก่อน ต่อมาคือจีน 23% รองลงมา นี่คือผู้ที่เข้าถึงอินเทอร์เน็ตไล่ไปเรื่อยๆ จนถึงไทย มีอยู่ 1% เป็น 1% ของประชากรที่ใช้อินเทอร์เน็ตได้ จาก 3,000 ล้านคน มีคนไทย 20 ล้านคน ถามว่าเยอะไหม เอาจริงๆ ถือว่าเยอะ

“ทีนี้ดูที่เว็บคอนเทนต์บ้าง เว็บคอนเทนต์มีภาษาอะไรบ้าง ปรากฏว่าพอไปค้นจริงๆ อังกฤษนำมาเลย อังกฤษมี 55% ของเว็บไซต์ 10 ล้านเว็บไซต์แรกที่ขึ้นในกูเกิล ค่อยๆ ไล่ไปเรื่อยๆ ภาษาที่รองลงมาคือรัสเซีย ไม่น่าเชื่อ แทนที่จะเป็นจีน ไม่ใช่ครับ จีนอยู่ที่ 3% เทียบกับอังกฤษ 55% ไทยอยู่ที่ 0.3% อยู่ใน top 30 ของภาษาที่มีในอินเทอร์เน็ต จริงๆ ข้อมูลภาษาไทยก็เยอะไม่ใช่เล่น ข้อมูลภาษาไทยก็เป็น big data ชนิดหนึ่ง”

ถ้าดูจากตรงนี้ ข้อมูลเว็บไซต์ทั้งหมดที่ค้นได้จากกูเกิล 10 ล้านอันแรก เป็นเว็บไซต์ไทย 30,000 เว็บไซต์

ปัญหาคือข้อมูลอยู่ในรูปแบบภาษาธรรมชาติ คือภาษามนุษย์ ภาษามนุษย์ไม่เหมือนตัวเลข ถ้าตัวเลขก็จับบวกกัน จับหาค่าเฉลี่ย ง่ายมาก แต่ข้อมูลที่อยู่ในรูปภาษา เราต้องไปแคะออกมา ที่เขียนข่าวมา 500 หน้า แก่นของข่าวอยู่ที่ไหน ข้อสรุปของข่าวอยู่ที่ไหน ใครทำอะไร ที่ไหน อย่างไร เมื่อไหร่ เราต้องไปหาวิธีการเข้าถึงข้อมูลที่เป็นภาษาธรรมชาติพวกนี้ ทางเดียวที่เป็นไปได้คือใช้คอมพิวเตอร์ไปเทรนด์ด้วยสถิติ ให้คอมพิวเตอร์ทำตัวเหมือนคน ไปนั่งอ่านข่าว แล้วก็แกะว่าประเด็นของข่าวอยู่ที่ไหน แต่การที่จะทำแบบนั้นได้จะต้องใช้ข้อมูลเยอะมาก ปัญหาคือมีบางภาษาที่ข้อมูลไม่ได้เยอะ ภาษาไทยถือว่าข้อมูลเยอะ แต่ถ้าเป็นภาษาบันตูในแอฟริกาใต้ หรือภาษาโคซาในแอฟริกาใต้ จะทำอย่างไร ภาษาพวกนี้มีปัญหาในการเข้าถึงข้อมูลทั้งนั้น

ต่อมา พอเราจะทำการวิเคราะห์ข้อมูลในอินเทอร์เน็ต เรามองภาษาเดียวไม่ได้ ภาษาอังกฤษอย่างเดียวไม่พอ ต้องมองข้ามภาษา เช่น มองไปที่ภาษาจีน ภาษาไทย ถ้าจะวิเคราะห์สถานการณ์ประเทศไทย การทำอย่างนั้นก็ต้องมองข้าม language barrier (อุปสรรคทางภาษา) คือเรามีกำแพงของภาษาที่คอมพิวเตอร์ข้ามไม่ได้ถ้าไม่มีเครื่องมือช่วย เครื่องมือช่วยที่ว่านี้คือ machine translation เครื่องแปลภาษา ถ้าเราจะคุ้นเคยก็คือกูเกิลทรานสเลท ถ้าเราจะทำการวิเคราะห์ข้ามภาษาแล้วจะทำการทำนายนั้นทำยากมาก มันต้องมีเครื่องมือหลายๆ ตัว เครื่องมือพวกนั้นเรียกว่า NLP การประมวลผลภาษาธรรมชาติ

ต่อมา พอเราพูดถึง NLP ก็ต้องตามด้วย application big data คืออะไร application นี้ก็คือ เราก็มองไปว่า เรามีทรัพยากรทางภาษาอะไรบ้างที่ให้ NLP ใช้ได้ แล้วเราจะเพิ่มเครื่องมือในการเข้าถึงข้อมูลเหล่านี้อย่างไร จะทำอย่างไรให้ machine translation เก่งขึ้น ทำอย่างไรให้ตัวอ่านข่าวอัตโนมัติและสรุปข่าวเก่งขึ้น

สุดท้าย data ที่มีในเว็บ จะเอาไปใช้ประโยชน์อะไรได้บ้าง NLP คือ AI (Artificial Intelligence, ปัญญาประดิษฐ์) + ภาษาศาสตร์ + ศาสตร์ในการเข้าใจความคิดของมนุษย์ (cognitive science) หลักๆ คือ หุ่นยนต์ มันคือหุ่นยนต์ที่ใช้ภาษามนุษย์ได้ และสามารถคิดได้แบบมนุษย์ จุดสูงสุดของ NLP คือแบบนี้จริงๆ คิดเหมือนมนุษย์ ใช้ภาษามนุษย์

นี่คือภาพของ NLP

เราจะพูดถึง Siri ตัว Apple หรือ Android จะมีเครื่องมืออยู่ตัวหนึ่ง เราสามารถคุยกับมันได้ สมมติว่าเราต้องการไปวัดพระแก้ว ก็คุยกับ Siri บอกทางไปวัดพระแก้วหน่อยสิ พูดเป็นภาษามนุษย์เลยครับ เจ้า Siri ก็จะแปลภาษามนุษย์ของเราให้กลายเป็นตัวหนังสือก่อน พอแปลเป็นตัวหนังสือปุ๊บ มันจะไปวิเคราะห์โครงสร้างประโยคของเราว่าอะไรคือแก่น อะไรคือสิ่งที่มันจะต้องสนใจ ไปวิเคราะห์โครงสร้างออกมา แล้วไปตีความหมายว่าจริงๆ เรากำลังถามทางอยู่ จุดเริ่มต้นคือธรรมศาสตร์ สมมติจะไปวัดพระแก้ว จุดปลายทางก็คือวัดพระแก้ว สร้างเป็นลอจิกขึ้นมา เสร็จแล้วมันก็ไปเปิดแผนที่ แล้วก็ได้เส้นทางออกมา พอได้เส้นทางก็คิดว่าจะพูดภาษามนุษย์อย่างไร เพื่อให้มนุษย์เข้าใจสิ่งที่มันสื่อได้ มันก็คิดรูปแบบมาแล้วว่าเดินตรงไปๆ เรื่อยๆ เลี้ยวซ้าย แล้วก็ถึงวัดพระแก้ว เสร็จแล้วมันก็เอาประโยคนี้มาสร้างเป็นเสียงพูดกลับมา เวลา Siri ทำงาน มันทำงานลึกขนาดนี้ ทำงานทุกขั้นในระดับในภาษาศาสตร์เลย

NLP ยังมีงานอื่นๆ อีก ไม่ใช่แค่เครื่องแปลภาษาเท่านั้น เครื่องสรุปข่าวก็มี โปรแกรม information retrieval คือตัวค้นคืนสารสนเทศ เช่น กูเกิล คือโปรแกรมค้นคืนสารสนเทศชนิดหนึ่ง โปรแกรมสกัดสารสนเทศ information extraction เช่น เราเอาข่าว 500 หน้ามา ต้องการรู้แค่ข่าวนี้ ใครทำอะไร ที่ไหน อย่างไร ถ้าเป็นข่าวอาชญากรรม มีเหยื่อไหม เหยื่อเป็นใคร ตายอย่างไร สกัดสิ่งที่ต้องการออกมา ทิ้งที่เหลือหมดเลย

เราสามารถทำ sentiment analysis ได้ด้วย คือการวิเคราะห์ความคิดเห็นของภาษาในโลกออนไลน์ เช่น ประโยครีวิวสินค้า เราต้องการจะบอกแค่อันนี้เป็นรีวิวบวกหรือลบ เราบอกได้ หรือแม้กระทั่งวิเคราะห์ สังเคราะห์เสียงพูด ก็เป็น NLP ชนิดหนึ่งเหมือนกัน

ทีนี้ พอมาพูดถึงภาษาไทย ภาษาไทยมีความพิเศษ พิสดาร ล้ำลึก แบบที่มนุษย์เขาไม่ทำกัน มันเกิดจากสิ่งที่เรียกว่า thought pattern คือ รูปแบบความคิด รูปแบบความคิดของคนไทยเป็นแบบตะวันออก หมายความว่าเวลาเราพูด เราเริ่มจากข้ออ้าง เช่น ก่อนหน้ามี 1 2 3 4 5 6 7 จนถึงเวลาอันเป็นอุดมมงคลฤกษ์ก็ค่อยพูดประเด็นที่สำคัญว่าจะทำอะไร การทำแบบนี้นะครับ มันเป็นการรักษาหน้าทั้งผู้พูดและผู้รับสาร

พอเป็นการรักษาหน้าก็หมายความว่าจริงๆ มันคือ “การขออภัยที่ต้องรบกวน” “ขอโทษนะคะที่ต้องมาให้อ่าน” “ขอโทษนะคะที่ต้องรบกวนอะไรขนาดนี้” เราเริ่มจากรายละเอียดวนๆ และจบด้วยประเด็นหลัก ชีวิตฝรั่งตรงกันข้ามกับเราครับ ฝรั่งเริ่มจากประเด็นหลัก อยากพูดอะไรเขาพูดก่อนแล้วค่อยหาเหตุผลมาสนับสนุน แล้วค่อยสรุปอีกทีเป็นครั้งสุดท้าย

ด้วยความที่ไทยมีความคิดเป็นแบบวน เราเรียกว่า ความคิดรวมศูนย์ หรือ collectivism collectivism จะสร้างความปั่นป่วนให้ภาษาของเราอย่างคาดไม่ถึงเลย เพราะว่าจริงๆ แล้วเวลาที่เราคิดแบบ collectivism เราชอบใช้ความหมายแฝง ความหมายแฝงคือ high-context meaning เรารู้กันอยู่ในกลุ่ม เรารู้กันอยู่แค่นี้ เราพูดอะไรเราก็ละก็ได้ เช่น ไม่ต้องพูดถึงประธาน ไม่ต้องพูดถึงกรรม เพราะเรารู้กันอยู่สองคน รู้กันในกลุ่ม พอใจแล้ว เช่น “วันนี้กินอะไร” “เอาอย่างเดิม ที่เก่า เวลาเดิม” รู้กันในกลุ่มแค่นั้น ฝรั่งพูดแบบนี้ไม่ได้ เขาจะไม่รู้

การทำแบบนี้ทำให้คอมพิวเตอร์มีปัญหาทันที เพราะคอมพิวเตอร์ถือว่าเป็นคนนอก เขาไม่ได้อยู่ในกลุ่มเรา แล้วเขาจะรู้ไหมว่าเราละไป เช่น ที่เก่าเวลาเดิม มันหมายความว่าอะไรกันแน่ คอมพิวเตอร์ไม่มีทางรู้ครับ การประมวลภาษาไทยเลยยากมาก

ตัวอย่าง บริบทบอกว่า สมชายฝากปลาทองไว้กับเพื่อนตอนไปทะเล ประโยคต่อมาบอกว่า เขาอยากนั่งตากลมโดยไม่ต้องห่วงเจ้าตากลม (ไม่รู้ว่า “ตากลม” ตัวแรกกับตัวหลัง เป็นคำไหนเป็น ตา-กลม คำไหนเป็น ตาก-ลม) ถ้ามองประโยคนี้ สมมติว่าคอมพิวเตอร์รู้ว่า เขาแรก ที่เราไม่รู้ว่าเป็นสรรพนามหรือว่าคำนาม (เขาสัตว์) เราไม่รู้สมมติว่าย้อนกลับไปหาสมชายได้ อ๋อ พอย้อนกลับไปหาสมชาย ก็แปลว่าจริงๆ คือสรรพนามสิ เพราะสามารถย้อนกลับไปหาสมชายได้ ตา-กลมหรือตาก-ลมก็ไม่รู้ สามารถย้อนไปหาทะเล บริบทของคือทะเล อ๋อ ถ้าคือทะเลก็น่าจะพูดถึง ตาก-ลม สิ

อีกอันก็เหมือนกัน ย้อนกลับไปหาปลาทอง คงชื่อตา-กลม เจ้า ป.ปลาตา-กลมไง คอมพิวเตอร์ทำได้ครับ แต่ไม่ 100% สิ่งที่คอมพิวเตอร์ทำได้คือใช้สถิติทำนาย การที่เอาสถิติมาทำนายบริบทแบบนี้ จะทำให้เราต้องเลือก (trade off) ระหว่างความแม่นยำของระบบกับเวลาที่ต้องรอ ถ้าต้องรอทุกคราวเมื่อดูว่าบริบทอยู่ที่ไหน รอไม่ไหว

ไปดูโซเชียลเน็ตเวิร์กกัน น่าสนใจมาก โซเชียลเน็ตเวิร์กสร้างพลวัตในภาษาศาสตร์กับภาษาไทยอย่างมาก พอเข้ามาปุ๊บก็ทำให้เกิดคำใหม่เต็มไปหมด ความหมายใหม่ก็เกิดขึ้นด้วย สถานการณ์ใหม่มาก็เกิดคำใหม่ เช่น เบนโล หรือบางครั้งเราพิมพ์ผิดโดยเฉพาะมือถือ ก็ได้คำใหม่ เช่น เมพ (เทพ) ครัช (ครับ) หรือการเลียนเสียงธรรมชาติ (onomatopoeia) เช่นคำว่า แว้น เสียงมอเตอร์ไซค์ แว้นๆ หรือการยืมภาษาเพื่อนบ้าน เช่น สก๊อย เป็นคำยืมนะครับ มาจากการ์ตูนญี่ปุ่นชื่อว่า secret agent ที่มีภาพลักษณ์เดียวกัน

สื่อในออนไลน์มีเยอะมาก ไม่ว่าจะเป็นเฟซบุ๊ก อินสตาแกรม ทวิตเตอร์ หรือแม้แต่ไลน์ ไลน์เมืองไทยใช้กันเยอะ พอไปอยู่ที่ประเทศอังกฤษ ไม่มีใครรู้จักไลน์ รู้จักแค่วอทซ์แอพ พวกนี้เป็น instant messenger หรือแม้แต่เว็บไซต์ทั้งหลายก็ถือเป็นสื่อออนไลน์เหมือนกัน

การที่ภาษาวิวัฒนาการได้เร็วขนาดนี้ มีข้อจำกัดอยู่อย่างคือมันไม่เสถียร ภาษาในกลุ่มนี้ไม่เสถียร ไดนามิกมาก คือเปลี่ยนแปลงตลอดเวลา แล้วเปลี่ยนแปลงตามเวลาด้วย ถึงเวลาหนึ่งคำพวกนี้จะหายไป เช่น มีใครยังใช้คำว่า “จ๊าบ” อยู่ไหม ปี 2539 คำนี้ฮิตมาก

ถ้ามีนักมานุษยวิทยา หรือนักสังคมวิทยา สนใจอยากไปดูเทรนด์ของภาษาพวกนี้ในโซเชียลเน็ตเวิร์ก เรามีเครื่องมือให้ NECTEC ทำไว้เยอะมาก เราสนใจภาษากลุ่มนี้อยู่แล้ว เครื่องมือนี้เรียกว่า essence ใช้แยกแยะว่าคนในโซเชียลเเน็ตเวิร์กกำลังพูดถึงเรื่องอะไรมากที่สุด สิ่งที่เราสนใจคือ แฮชแท็ก คือ # ตามด้วยข้อความ จะบอกอารมณ์ หัวข้อเรื่อง สิ่งที่สนใจ เฟซบุ๊กก็มี ทวิตเตอร์ก็มี เช่น #เรื่องเดี่ยว11 #ตีแผ่ชีวิตมหาลัย #ร้องไห้หนักมาก #รู้ยัง essence จะตรวจจับสิ่งพวกนี้แล้วทำเป็นกราฟ พร้อมบอกว่าแฮชแท็กไหนเกิดขึ้นบ่อยๆ ตัวจะใหญ่ มีตั้งแต่ระดับวัน อาทิตย์ เดือน ศึกษาได้ตลอด

เรื่องแฮชแท็ก บางทีผมก็ตามไม่ทันเหมือนกันครับ ได้แต่นั่งมอนิเตอร์ essence ว่าตอนนี้คนพูดเรื่องอะไรมากกว่ากัน

อีกเรื่องที่น่าสนใจคือ sentiment analysis การวิเคราะห์ความคิดเห็น การวิเคราะห์ความคิด เราสามารถทำนายได้ คือทำนายขั้วบวกลบของการรีวิวสินค้า หรือว่าการเหยียดเพศ hate speech พวกนี้เป็น polarity (มีความเป็นขั้ว) มีบวกลบ ถ้าบวกแปลว่าเป็น hate speech ลบแปลว่าไม่ใช่ hate speech

เราสามารถใช้ NLP มาแยกแยะได้ว่าข้อมูลพวกนี้เป็นบวกหรือลบ เช่น โทรศัพท์…เต็มเปี่ยมไปด้วยความพรีเมียมที่ยอดเยี่ยมกว่าเคย อันนี้เป็นบวกหมดเลย อีกอัน ไม่มีการติดต่อกลับมาใดใด จนเราต้องเป็นฝ่ายอีเมลไปถามว่าเรื่องไปถึงไหนแล้ว ลบล้วนๆ ลบตั้งแต่ยังไม่มีการติดต่อกลับ คำว่าต้องก็เป็นลบ อีเมลไปถามก็ลบ เรื่องถึงไหนแล้วก็ลบ แสดงว่าข้อความนี้เป็นลบ

แต่คนไทยเรามีการประชด เช่น ร้านxxx บริการสุดประทับใจ ไปทานอาหารมาสองครั้ง ออร์เดอร์หายทั้งสองครั้ง แถมครั้งสุดท้ายที่ไป เด็กเสิร์ฟยังคิดค่าอาหารผิด เอาออร์เดอร์ที่หายไปรวมกับบิลที่หาย ข้างหน้าเป็นบวก ข้างหลังเป็นลบกระจุย อย่างนี้เรียกว่าการประชด การประชดจริงๆ คือความหมายลึกของรูปประโยคนั้นตรงข้ามกับความหมายตื้น ความหมายตื้น (ambivalence) ถ้าดูรูปคำอย่างเดียวมันเป็นบวก ถ้าอ่านลึกจะเป็นลบ

เรายังมีสิ่งที่ต้องไปสำรวจใน NLP อีกเยอะ โดยเฉพาะในภาษาไทย

สรุปคือ big data เป็นเรื่องของข้อมูลขนาดใหญ่ ที่ประมวลผลด้วยวิธีการปกติไม่ได้ big data จะควบคู่ไปกับการวิเคราะห์เชิงทำนาย (predictive analytics) อินเทอร์เน็ตคือ big data ชนิดหนึ่ง NLP จะช่วยให้ทำการวิเคราะห์ข้อมูลขนาดใหญ่ได้ เพราะข้อมูลเป็นภาษา ภาษาไทยมีความท้าทายอยู่หลายอย่างในการทำ NLP และโซชียลเน็ตเวิร์กทำให้เกิดพลวัตในภาษาไทยมากและภาษาเปลี่ยนตลอดเวลา”